Künstliche Intelligenz - ein Marketingbegriff

Künstliche Intelligenz - ein Marketingbegriff

Die Entstehung des Begriffs „Künstliche Intelligenz“ ist banaler, als man denkt: Er geht zurück auf den Stanford-Professor John McCarthy. Der erfand ihn 1955, um Geld für ein zweimonatiges Forschungsprojekt im Sommer 1956 zu bekommen. Eine Erklärung oder formale Definition des Begriffs sucht man in seinem Förderantrag vergeblich. Überhaupt taucht er darin eher als Oberbegriff auf. „In der Studie wird davon ausgegangen, dass jeder Aspekt des Lernens beziehungsweise jedes weitere Merkmal von Intelligenz im Prinzip so präzise beschrieben werden kann, dass die Entwicklung einer Maschine zur Simulation aller einzelnen Schritte möglich wird“ (McCarthy et al. 1955). Dann werden „einige Aspekte des Problems künstlicher Intelligenz“ aufgeführt. Das wars. Ein Marketingbegriff also. McCarthy bekam das Geld und der Begriff war in der Welt. Doch genau zu beschreiben, was Intelligenz ist, misslang (vgl. Brooks 2018; Whittaker 2023).

Hier setzt auch die aktuelle Kritik am Begriff Künstliche Intelligenz (KI) an. Denn bis heute gibt es keine allgemeine Definition von Intelligenz. Wenn wir also schon nicht wissen, was menschliche Intelligenz ausmacht – wie sollen wir dann eine künstliche Intelligenz definieren? Doch auch, wenn der Begriff nicht eindeutig ist, so ist KI nun da.

KI ist nicht neu, die Forschung darüber schon gar nicht. Neu ist aber seit 2022, dass Programme, die mit generativer KI arbeiten, nun für alle zugänglich und sehr einfach nutzbar sind. Es ist also an der Zeit, sich einmal genauer anzuschauen, was dahintersteckt.

Automatisierte Texte

Wenn es derzeit darum geht, wie KI im Journalismus eingesetzt wird, so werden nicht selten zwei völlig unterschiedliche Herangehensweisen in einen Topf geworfen: das automatisierte Erstellen von Inhalten einerseits und die Generierung synthetischer Inhalte durch den Einsatz großer Sprachmodelle (-> Glossar) andererseits. Diese Unterscheidung ist aber für uns Journalistinnen und Journalisten von zentraler Bedeutung. Denn bei automatisiert erstellten Texten können wir das Ergebnis und bei Bedarf auch Fehler nachvollziehen, bei den Ergebnissen von Sprachmodellen bisher nicht. Warum? Bei der reinen Automatisierung macht der Mensch so genaue Vorgaben, dass die Ergebnisse nachvollziehbar bleiben. Sprachmodelle generieren Inhalte hingegen eigenständig, so dass diese Nachvollziehbarkeit fehlt.

Für automatisierte Texte braucht es zweierlei: Strukturierte Daten wie etwa eine Tabelle mit Wetterdaten, Wahlergebnissen oder Sportereignissen und ein Programm wie Retresco oder AX Semantics, in dem Textbausteine vorbereitet und Regeln vorgegeben werden, nach denen dann automatisiert Texte erstellt werden.

Die Nachrichtenagentur Associated Press (AP) nutzte diese Technik schon 2014, um automatisiert Texte über Quartalsberichte börsennotierter Unternehmen verfassen zu lassen. Inzwischen ist die Liste der Einsatzbereiche lang. Das Magazin Der Spiegel stellte zur Bundestagswahl 2021 auf diese Weise auch Einzelanalysen für alle 299 Wahlkreise zur Verfügung.

Diese Art der Texterstellung kann Routinen erleichtern und eröffnet neue Möglichkeiten. KI ist das aber noch nicht.

Entwicklungsstufen Künstlicher Intelligenz

Entwicklungsstufen Künstlicher Intelligenz

Um zu verstehen, was hinter dem steckt, was wir als Künstliche Intelligenz bezeichnen, und wie sie funktioniert, werden wir die Motorhaube heben und uns anschauen, was sich darunter verbirgt. Was bezeichnen Begriffe wie Künstliche Neuronale Netze, Transformer oder GPT? Dieses Wissen gehörte bislang nicht zum Repertoire von uns Medienschaffenden. Wenn wir nun aber beginnen, KI-Anwendungen im Redaktionsalltag zu nutzen, sollten wir hiervon ein Grundverständnis haben. Wer Auto fährt, muss zwar weder ein Auto bauen noch es reparieren können. Den Motor von Tank und Auspuff zu unterscheiden, gehört hingegen durchaus zum Allgemeinwissen des 20. Jahrhunderts. Zum Allgemeinwissen des 21. Jahrhunderts wird es bald auch gehören, ein grundlegendes Verständnis von KI-Technologien zu haben. Doch wie hängen Künstliche Intelligenz, Maschinelles Lernen, Künstliche Neuronale Netze, Tiefes Lernen und generative KI zusammen? Wo liegen die Unterschiede? Und was muss man darüber wissen?

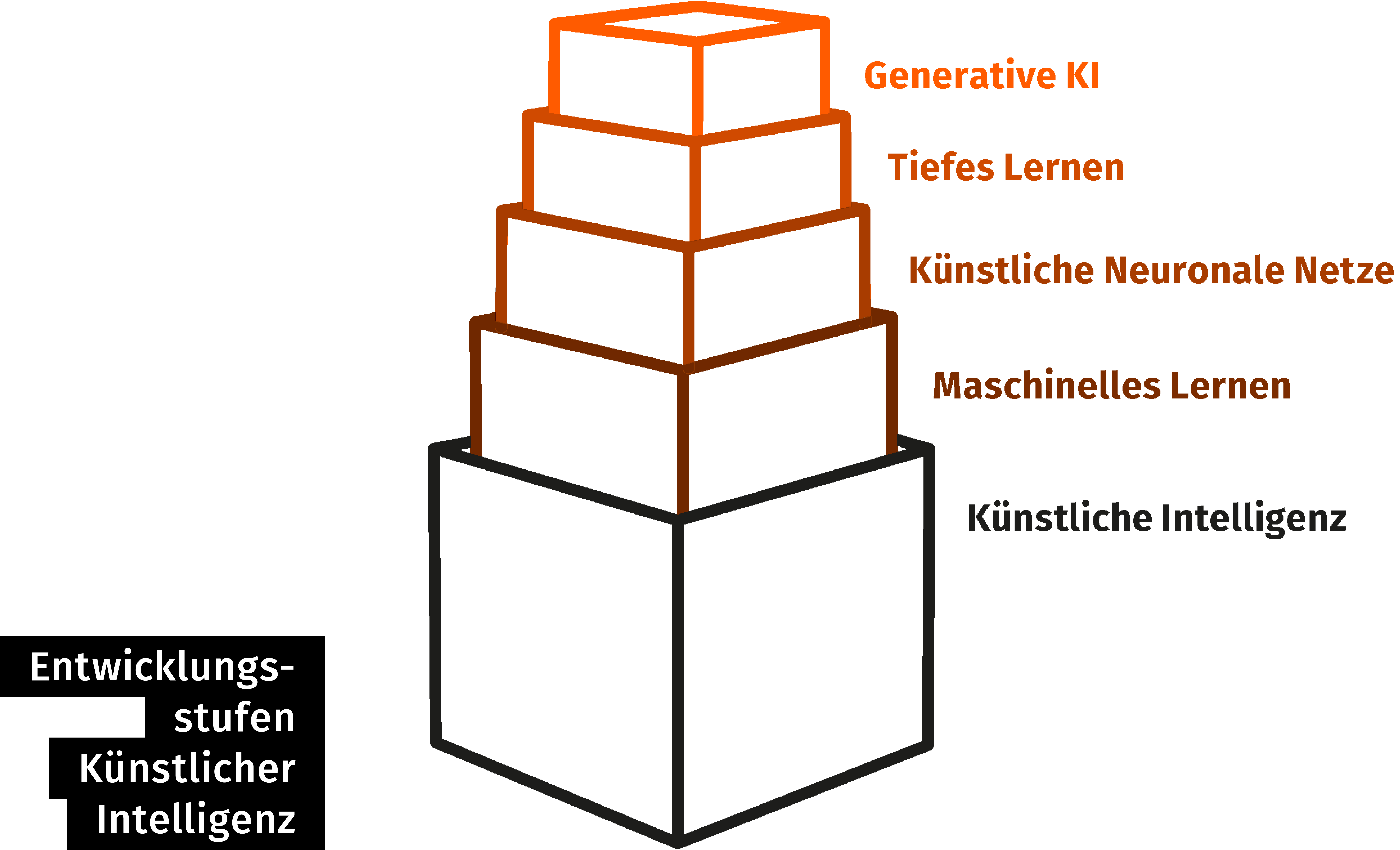

Um das zu verstehen, kann es uns helfen, die technologische Entwicklung mit dem Bau eines Stapelturms zu vergleichen. Stapeltürme gibt es in vielen Kinderzimmern und in verschiedenen Ausführungen. Der Klassiker besteht aus hohlen Holzwürfeln, die an einer Seite offen sind und sich in absteigender Größe aufeinander stapeln lassen. Je höher der Turm wird, desto wackeliger wird er. Für kleine Kinder ist das Stapeln eine Herausforderung, gilt es doch zu verstehen in welcher Reihenfolge die Würfel stabil stehen. Für noch kleinere ist es ein großer Spaß, die Türme zum Einstürzen zu bringen. Eltern wiederum freuen sich, dass sich die Würfel platzsparend ineinander stapeln lassen – alle in den größten hinein.

Ähnlich wie beim Stapelturm war es in der Entwicklung von KI: Generative KI ist nicht plötzlich entstanden, sondern nach und nach. Jede Stufe baut jeweils auf den Erkenntnissen der vorherigen auf. Generative KI, die uns im Moment am meisten beschäftigt, ist die am weitesten fortgeschrittene Technologie im Kontext Künstlicher Intelligenz und ist daher der oberste Würfel unseres Turms.

Expertensysteme

Der größte und erste Würfel unseres imaginären Stapelturmes ist Künstliche Intelligenz. Davon sprechen Expertinnen und Experten, wenn Maschinen in der Lage sind, automatisiert sinnvolle Ergebnisse zu liefern, ohne dass ihnen die Programmierung konkrete Lösungswege vorgibt. Das Fraunhofer-Institut für Kognitive Systeme IKS erklärt es so: „Künstliche Intelligenz imitiert menschliche kognitive Fähigkeiten, indem sie Informationen aus Eingabedaten erkennt und sortiert“ (IKS 2024).

In der Geschichte der KI haben Forschende zunächst versucht, Software alle notwendigen Regeln zu geben, mit dem Ziel, dass die Systeme daraus eigene Entscheidungen ableiten können. Ein solches sogenanntes Expertensystem war auch der 1966 vorgestellte und damit weltweit erste Chatbot ELIZA, der einen Psychotherapeuten nachahmen sollte. Auch die Verarbeitung menschlicher Sprache sollten Programme zunächst über die Eingabe diverser Regeln lernen. Das gelang allerdings nur mit mäßigem Erfolg. Denn es stellte sich heraus, dass die Regeln, denen Sprache folgt, zu komplex sind. Daher wurde nach neuen Wegen gesucht. Für die heute wichtigen KI-Anwendungen ist Maschinelles Lernen von zentraler Bedeutung.

Maschinelles Lernen

Maschinelles Lernen („machine learning“) ist ein Teilbereich von Künstlicher Intelligenz und damit unser zweiter Ring. Es unterscheidet sich vom größeren Feld der KI dadurch, dass hier Computer aus Daten selbst etwas „lernen“ und eben nicht über Regeln. Dabei wird ein Lernalgorithmus mit sehr großen Datenmengen gefüttert. Aus der Analyse all dieser Daten leitet der Algorithmus dann Zusammenhänge ab und entwickelt für sich ein statistisches Modell. Manchmal werden solche Prozesse von menschlichem Feedback begleitet, manchmal aber auch nicht. Je nach Methode spricht man von überwachtem Lernen („supervised learning“) oder unüberwachtem Lernen („unsupervised learning“). Welche Lernmethode gewählt wird, hängt von den Entscheidungen der Programmierenden ab und ist Teil des Lernalgorithmus.

Das statistische Modell, das die Software während des Lernprozesses entwickelt, ist, nach dem Trainingsprozess, dann die Grundlage für Vorhersagen der Software. Das heißt, die Software kann dann ihr Modell später auf andere, ihr bis dahin unbekannte Daten anwenden und ebenso korrekte Antworten generieren.

Ab diesem Punkt der technologischen Entwicklung beginnt es für Menschen undurchsichtig zu werden. Denn: „Die Entwicklerinnen und Entwickler geben der Maschine dabei nur die grobe Struktur vor. Die Feinheiten werden durch die lernende Methode in Zusammenwirkung mit den Daten festgelegt“, erklärt Informatikprofessorin Katharina Zweig (2023). Das heißt: Was wir als Lernen der Maschine bezeichnen, ist ein Prozess, der auch von den Programmierenden nicht mehr vollends nachvollzogen werden kann. Sie können sich zwar das statistische Modell anschauen, das die Software im Lernprozess entwickelt. Wie genau aber das System dazu gekommen ist, können auch Fachleute nur erahnen.

Die Theorie des Maschinellen Lernens ist ebenso wie die der Künstlichen Intelligenz schon mehr als 70 Jahre alt. Das erste wissenschaftliche Papier dazu schrieb Alan Turing. Es ging den Fragen nach: Können Maschinen denken? Und wie ließe sich das testen? Veröffentlicht wurde es 1950 und damit noch bevor der Begriff „Künstliche Intelligenz“ erfunden war. Es blieb dann zunächst bei der Theorie – denn für die Umsetzung und das Testen der Ideen fehlten lange zwei Dinge: Daten und Rechenpower.

Punktuell gab es wichtige Erfolge: So etwa, als der Schachcomputer Deep Blue von IBM 1996 den damaligen Schachweltmeister Gary Kasparow besiegte. Gut zwanzig Jahre danach gelang es 2017 einem Computer namens AlphaGo, den die Google-Tochter Deepmind konstruiert hatte, den weltweit besten Spieler im Spiel Go, Ke Jie, zu besiegen. Doch der Durchbruch in der Anwendbarkeit ließ noch auf sich warten.

Künstliche Neuronale Netze

Bei der weiteren Entwicklung erwiesen sich dann ausgerechnet Katzenvideos als nützliche Ressource. Womit wir bei der dritten Entwicklungsstufe und dem nächsten Würfel unseres Turms wären: Künstlichen Neuronale Netzen.

Dieser Begriff bezeichnet eine spezielle Methode des Maschinellen Lernens, die schon 1943 erfunden wurde (vgl. Brooks 2018). Bis zu ihrem Durchbruch dauerte es aber eine ganze Weile. Inzwischen wird sie gern bei komplexen Lernprozessen eingesetzt. Künstliche Neuronale Netze sind sehr ausgefeilte Algorithmen, deren Strukturen das menschliche Gehirn mit Neuronen und Synapsen zum Vorbild haben. Was im Gehirn Neuronen sind, ist im Algorithmus jeweils eine Rechenanweisung – genauer gesagt eine mathematische Funktion. Diese instruiert die Software, eine Reihe von Eingabewerten auf eine bestimmte Weise zusammenzuzählen. Diese Ergebnisse werden dann zu den Eingabewerten der nächsten Ebene.

So, wie die Synapsen im Gehirn Reize erst ab einer gewissen Intensität weiterleiten, bestimmt auch der Algorithmus, wie stark ein einzelnes Ergebnis weitergegeben und in der nächsten Ebene berücksichtigt wird. Das führt zu dem Effekt, dass – vergleichbar wie beim menschlichen Gehirn – nicht alle Ergebnisse gleichermaßen berücksichtigt werden.

Ein einfaches Künstliches Neuronales Netz hat drei Ebenen: Eine Eingabe-Ebene, eine verdeckte Ebene und eine Ausgabe-Ebene. Auf der Eingabe-Ebene stehen von Menschen konzipierte Rechenformeln. Sie machen der Maschine Vorgaben und setzen den Rechenprozess in Gang. Die Rechenergebnisse dieser ersten Ebene werden von der zweiten Ebene eigenständig weiterverarbeitet. Die Berechnungen für die verdeckte Ebene sind vorgegeben.

Der „Lernprozess“ der Maschine bezieht sich darauf, in vielen Durchgängen die Gewichtungen festzulegen, mit denen die Ergebnisse der ersten Ebene in die Berechnungen der nächsten Ebene einfließen. Diese zweite Ebene aber ist verdeckt – hier rechnet der Algorithmus mit den Ergebnissen der ersten Ebene und den von ihm selbst entwickelten Gewichtungen weiter. Einen Einblick in diese Ebene haben die Programmierenden nicht. Das ist ein Charakteristikum Künstlicher Neuronaler Netze und der Hintergrund, warum KI oft auch als Black Box beschrieben wird.

Tiefes Lernen

Was hat das nun mit den Katzenvideos zu tun? Wie erwähnt, fehlte für die Entwicklung Künstlicher Intelligenz lange eine ausreichend große Menge verfügbarer Daten. Das änderte sich in den Nullerjahren. Nach der Gründung von YouTube 2005 wurden dort millionenfach Videos hochgeladen. Ein Datenschatz, den sich der Informatiker Andrew Ng zunutze machte: Er verwendete einen Trainingsdatensatz mit zehn Millionen Videos dazu, ein Künstliches Neuronales Netz auf das Erkennen von Katzen in Videos zu trainieren. Sein Ziel war dabei, dass die Software lernen sollte, wie eine Katze aussieht, ohne dass er es der Software vorher gezeigt hatte (vgl. DataScientest 2023). Das war der Beginn einer neuen Ära: der des sogenannten Tiefen Lernens („deep learning“), dem vierten Würfel unseres Stapelturms.

Beim Deep Learning oder auch Tiefen Lernen werden neuronale Netze mit sehr vielen Ebenen eingesetzt. Ein Künstliches Neuronales Netz, das mindestens zwei dieser versteckten Ebenen hat, wird schon als Tiefes Neuronales Netz bezeichnet. Laut Fraunhofer IKS (2024) können sie aber sogar bis zu Hunderttausende oder Millionen Schichten haben. Können wir uns das noch vorstellen? Hunderttausende aufeinanderfolgende Ebenen, auf denen jeweils unzählige parallele Rechenoperationen ausgeführt werden... Zu Gesicht bekommen wir davon nur das Ergebnis: Katze erkannt! – und sind verblüfft.

Generative KI

Noch verblüffender sind die Möglichkeiten der nächsten Entwicklungsstufe von KI – dem obersten Würfel unseres Turms: generativer KI. Seit die Firma OpenAI im November 2022 ChatGPT für die Allgemeinheit freigegeben hat, kommen immer mehr Angebote hinzu. Claude, Imagen, Sora und andere Tools können in Windeseile Texte, Bilder und Videos generieren.

Doch was unterscheidet diese Art von KI nun von den anderen Bereichen, die wir schon betrachtet haben? Auf den Punkt bringt das der leitende KI-Experte der New York Times, Zach Seward (2023): „Wenn traditionelles Maschinelles Lernen gut Muster in einem Haufen ungeordneter Daten erkennen kann, so könnte man sagen, dass die Superpower generativer KI darin liegt, Muster zu kreieren.“

KI-Anwendungen werden in der Regel jeweils für eine spezifische Aufgabe entwickelt. Das gilt für die Antworten des Robo-Therapeuten ELIZA genauso wie für das Erkennen von Katzen in Videos und ebenso für generative KIs. Die großen Sprachmodelle (-> Glossar) sind dabei auf eine sehr komplexe und umfangreiche Aufgabe trainiert worden: das Verarbeiten von natürlicher Sprache.

Deswegen heißen sie auch Sprachmodelle. Ihr statistisches Modell ist darauf trainiert, die Wahrscheinlichkeit von Wortteilen und Sätzen vorherzusagen – zum Beispiel auch die Sequenz „Alle meine Entchen … “ zu vervollständigen.

Transformer

Möglich wird das in der aktuellen Qualität und Schnelligkeit durch so genannte Transformer. ChatGPT trägt das Wort sogar im Namen: GPT steht nämlich für Generative Pretrained Transformer – es beschreibt also auf Englisch, womit wir es hier zu tun haben: einem generativen vortrainierten Transformer. Transformer bezeichnet dabei die Art des Lernalgorithmus. Vortrainiert beschreibt, dass das Modell zunächst trainiert werden muss, bevor es einsatzbereit ist, und dann aber auch weiterhin verbessert werden kann. Und

generativ beschreibt schließlich die Art des Outputs – etwas neu Geschaffenes.

Technisch ist ein Transformer eine speziell aufgebaute Deep-Learning-Architektur eines Künstlichen Neuronalen Netzwerks. Sie wurde 2017 erstmals auf einer Fachkonferenz vorgestellt und hat seitdem die Verarbeitung natürlicher Sprache revolutioniert. Denn die besondere Herausforderung bei der Verarbeitung von Sprache im Unterschied zu numerischen Daten ist, dass Wörter je nach ihrer Platzierung im Satz und auch trotz gleicher Schreibweise unterschiedliche Bedeutungen haben können. Es kommt also auf den Sinnzusammenhang an.

Um Text zu verarbeiten, muss dieser zunächst in Zahlen übersetzt werden. Transformer-Modelle sind erstmals in der Lage, auch die Position der Wörter im Satz in numerischen Werten zu markieren und dadurch den Kontext von Wörtern besser zu erfassen. Zudem ist es durch Transformer erstmals möglich, dass Algorithmen lernen, welche Teile der eingespeisten Daten am relevantesten für einen bestimmten Output sind (vgl. Klofat 2023 und Clarke et al. 2023).

Im Fall von ChatGPT haben wir es mit einem sehr großen Sprachmodell zu tun, dessen Aufgabe es ist, Sprache zu verarbeiten und zu generieren. Ähnlich verhält es sich mit anderen Angeboten.

Der Chatbot von Open AI, ChatGPT, basiert – je nach Tarif – auf den Modellen GPT 3.5, GPT 4 oder GPT 4o. Weil diese Modelle für verschiedene Aufgaben weitertrainiert werden können, heißen sie auch Basismodelle oder Grundmodelle („foundation models“).

Sind große Sprachmodelle (LLM) und Basismodelle also das Gleiche? Nein, nicht ganz. Der Begriff Basismodelle umfasst zwar die großen Sprachmodelle. Aber er erfasst darüber hinaus auch Modelle, die nicht Sprache erzeugen, sondern Bilder oder Videos. Denn während Sprachmodelle ausschließlich mit Textdaten trainiert werden, werden andere Basismodelle wie beispielsweise DALL-E von Open AI neben Textdaten auch mit Bilddaten trainiert und Sora auch mit Videodaten. Entsprechend haben sie auch andere Fähigkeiten wie das Generieren von Bildern, Audio oder Videos.

Bekannte KI-Modelle

Bekannte KI-Modelle

Die Firma OpenAI wurde 2015 gegründet und bietet neben ChatGPT für Text mit DALL-E auch ein Tool an, das Bilder aus Textbeschreibungen generieren kann. Mit Sora kommt bald noch ein Werkzeug hinzu, das Videos aus Texteingaben erstellen kann. Mit ChatGPT 3.5 gibt es eine kostenfreie Version. Das leistungsfähigere Sprachmodell ChatGPT 4.0 liegt dem kostenpflichtigen Angebot ChatGPT+ zugrunde. Tatsächlich liefert die kostenlose Variante weit weniger eloquente Ergebnisse und macht mehr Fehler als ChatGPT 4.0. Mit ChatGPT 4o gibt es seit Mai 2024 zudem ein drittes Modell, das Text, Video und Audio verarbeiten kann.

Software-Anbieter Microsoft hat seit 2019 mehr als 13 Milliarden US-Dollar in OpenAI investiert und sich so Zugang zu dessen Technologie gesichert. Daher beruht das KI-Angebot von Microsoft, das unter dem Namen Copilot bekannt ist, auch auf ChatGPT. Copilot kann direkt aus Microsoft-Anwendungen wie Word, Excel oder PowerPoint aufgerufen werden. Darüber hinaus kooperiert Microsoft mit Meta. Und außerdem entwickelt das Unternehmen ein eigenes KI-Sprachmodell namens MAI-1, das mit den Modellen von Google und OpenAI konkurrieren soll.

Der Facebook-Mutterkonzern Meta Platforms hat im Februar 2023 sein Sprachmodell LLaMA veröffentlicht. Die Abkürzung steht für Large Language Model Meta AI. Der Code, den das Modell bei der Ausführung von Anfragen verwendet, ist frei zugänglich. Im Juli 2023 ist in Kooperation mit Microsoft das Nachfolgemodell LLaMA 2 erschienen, das ebenfalls Open Source ist. Neben Text und Bildern kann LLaMa 2 auch Code generieren. Im April 2024 stellte Meta LLaMA 3 vor.

Google hat als Reaktion auf den Release von ChatGPT im Februar 2023 den Chatbot Bard veröffentlicht, den das Unternehmen im Februar 2024 in Gemini umbenannt hat. Die Modelle, die dem zugrunde liegen, sind unterschiedlich in Größe und Funktionsumfang und teils kostenpflichtig. Die aktuelle Version kann verschiedene Arten von Inhalten, wie Text, Bilder, Audio und Video, verarbeiten. Insgesamt sind die Funktionen denen von OpenAI sehr ähnlich. Gemini gibt es auch als App.

Anthropic ist ein 2021 von ehemaligen OpenAI Mitarbeitenden gegründetes Unternehmen, das sich der Entwicklung einer sicheren und verständlichen KI verschrieben hat. Sein Sprachmodell Claude kann Texte generieren und fokussiert sich dabei besonders auf KI-Sicherheit. Die im März 2024 veröffentlichte Version Claude 3 umfasst drei Modelle, die auf verschiedene Kundentypen und Anwendungsfälle angepasst sind. Lange war Claude nur in den USA und Großbritannien verfügbar, inzwischen gibt es das Angebot auch in der EU. Hauptzielgruppe sind zwar Unternehmen, dennoch ist Claude auch für Einzelpersonen und die allgemeine Nutzung zugänglich. Im Juni 2024 stellte Anthropic mit Claude 3.5 Sonnet ein Sprachmodell vor, das sowohl Text als auch Bilder analysieren kann.

Midjourney ist ein unabhängiges Forschungslabor aus San Francisco. Es wurde im Juli 2022 gegründet und hat sich auf die Generierung von Bildern aus Textbeschreibungen spezialisiert. Zugänglich ist das gleichnamige Tool über einen Chatbot auf der Plattform Discord. Die Anwendung ist kostenpflichtig und ermöglicht es Nutzenden, über die Eingabe von Textanweisungen, Bilder zu generieren. Midjourney zeichnet sich dadurch aus, dass es spezifische künstlerische Stile und Bildinterpretationen ermöglicht und sehr fotorealistische Bilder produzieren kann.

Die Firma Stability AI, die 2019 von Emad Mostaque in London gegründet wurde, arbeitet ebenfalls vor allem an der Entwicklung von bildgenerierenden KI-Anwendungen. Flaggschiff ist das Tool Stable Diffusion, dessen Code von einem Team der Universität München entwickelt und frei zugänglich veröffentlicht wurde. Stability AI unterscheidet sich von DALL-E und Midjourney durch seinen Open-Source-Ansatz, der Entwicklerinnen und Entwicklern ebenso wie Unternehmen einen leichteren Zugang sowie die Möglichkeit bietet, das Modell an spezifische Bedürfnisse anzupassen. Inzwischen lassen sich mit diesem Werkzeug zum Teil auch schon kurze Video-Sequenzen und animierte Bilder erstellen.

Die deutsche Firma Aleph Alpha arbeitet seit 2019 an einem großen Sprachmodell mit dem Namen Luminous. Es ist noch in der Entwicklung und wird derzeit nicht für die breite Öffentlichkeit angeboten, vielmehr richtet es sich an Unternehmen und Organisationen. Ziel von Aleph Alpha ist es, die Sicherheit und Anwendbarkeit von KI im europäischen Kontext zu erhöhen, indem sie die Einhaltung von Datenschutzbestimmungen garantieren und maßgeschneiderte Lösungen für lokale Märkte bieten. Zudem möchte Aleph Alpha für die Nutzenden nachvollziehbar machen, wie die KI Luminous zu ihrer Entscheidung kommt. Erste Kunden sind beispielsweise Bosch, SAP und verschiedene Kommunalverwaltungen.

Das französische Start-up Mistral ist gerade mal ein Jahr alt und derzeit die große Hoffnung der europäischen KI-Szene. Gegründet wurde es im April 2023 von drei Software-Entwicklern: Guillaume Lample und Timothée Lacroix waren früher beim Facebook-Mutterkonzern Meta an der Entwicklung von LLaMA beteiligt und Arthur Mensch war Mitarbeiter von Deepmind, der KI-Tochter von Google. Seinen Sitz hat Mistral in Paris, investiert wird inzwischen aber größtenteils aus den USA – darunter Wagniskapitalgeber Andreessen Horowitz, der Software-Konzern Salesforce und Microsoft. Le Chat heißt das Angebot von Mistral, dessen Betaversion derzeit nach einer Registrierung nutzbar ist. Wie Aleph Alpha richtet sich auch Mistral primär an Unternehmen und Organisationen. Zur Kundschaft gehören die Bank BNP Paribas und der Mobilfunkanbieter Orange.

Konstruktiver KI-Kompass

Künstliche Intelligenz verstehen und nutzen, um die eigene journalistische Arbeit konstruktiver zu machen – das bietet der Konstruktive KI-Kompass.

Unsere Inhalte gibt es alle online. Zudem steht das geballte Wissen im gleichnamigen E-Book kostenlos zum Download bereit: